部分内容由谜题科技的决策大模型“Enigma”撰写)

近日,上海数字大脑研究院(简称“数研院”)联合中英高校团队对于使用Transformer模型解决序贯决策任务的研究提供了全面的综述,为建立大型决策大模型提供了一系列潜在的研究方向。该论文已被SCI期刊Frontiers of Computer Science(FCS)收录。

Frontiers of Computer Science(简称FCS)是计算机科学领域的重要期刊之一,该期刊涵盖了计算机科学的各个领域,包括计算机系统、网络、软件工程、人工智能、计算机视觉、计算机图形学等。其SCI影响因子目前在计算机科学领域排名前列,发表在该期刊上的论文也受到广泛关注和引用。

Transformer 架构促进了大规模和通用的序贯模型在自然语言处理和计算机视觉中的预测任务中的发展,例如GPT-3和Swin Transformer。尽管它最初是为预测问题设计的,但人们自然而然地会好奇它们在序贯决策和强化学习问题中的适用性,因为这些问题长久以来一直受样本效率低下、信用分配困难和部分可观察特性的困扰。近年来,序贯模型,特别是Transformer,在强化学习社区中也受到了越来越多的关注,孕育出许多效果显著和泛化能力出众的方法。为了吸引更多研究者关注这一趋势性的话题,使其落地于更多实际应用中,如机器人、自动车辆和自动化工业,数研院通过调查研究、深入探索后特发表本篇报告。

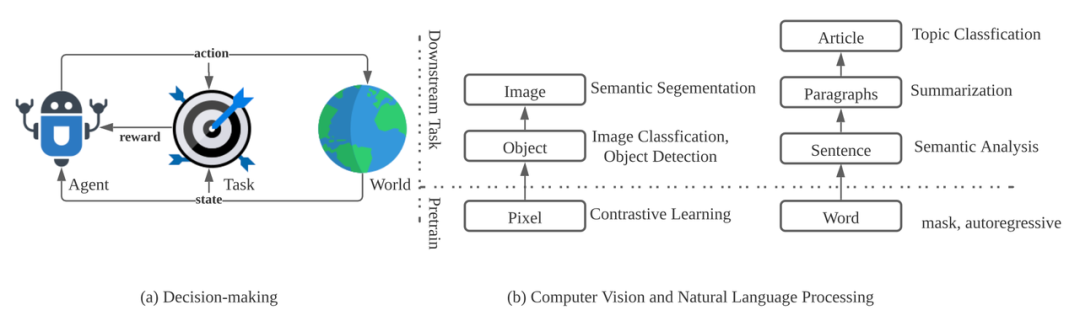

图1:序贯决策任务和预测任务(如计算机视觉和自然语言处理)之间的区别:(a) 序贯决策任务是由代理、任务和世界构成的交互循环;(b) 在预测任务中,任务则是一个层次结构

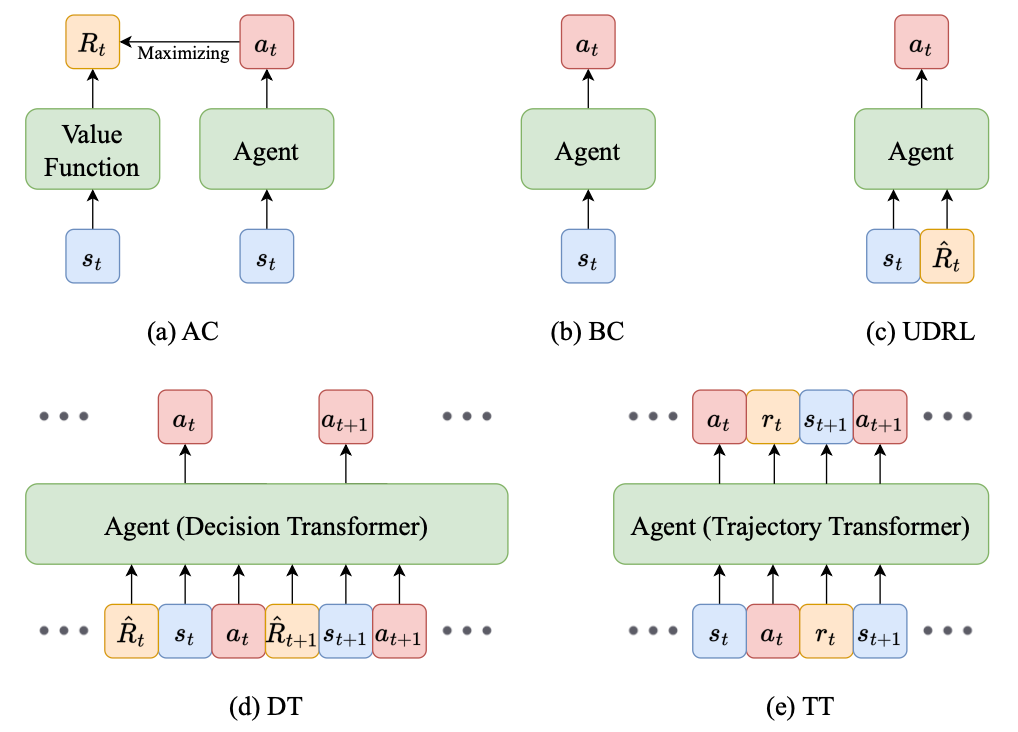

数研院在文章中对于使用基于Transformer的决策模型解决序贯决策任务的研究提供了全面的综述,讨论了序贯决策与序贯模型之间的联系,并根据它们利用Transformer的方式进行分类。这些工作表明了构建一个大型通用决策模型的潜力,即一个拥有巨量参数大型序贯模型,可以执行数百个或更多的不同种类的序贯决策任务,与大规模序贯模型在NLP和CV中的利用方式类似。图2:AC(Actor-critic)、BC(Behavioral cloning)、UDRL(Upside-down reinforcement learning)、DT(Decision Transformer)、TT(Trajectory Transformer)的范式比较

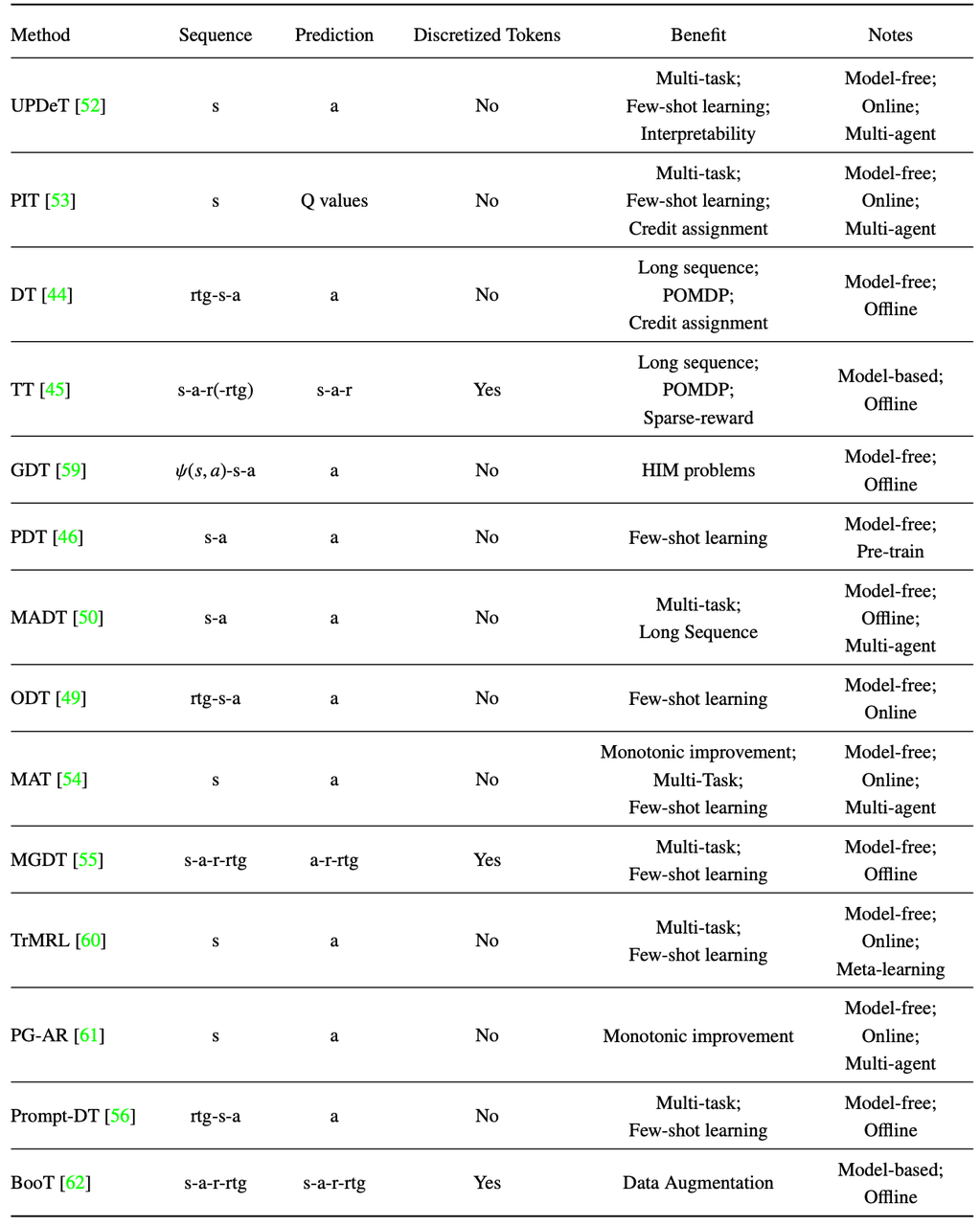

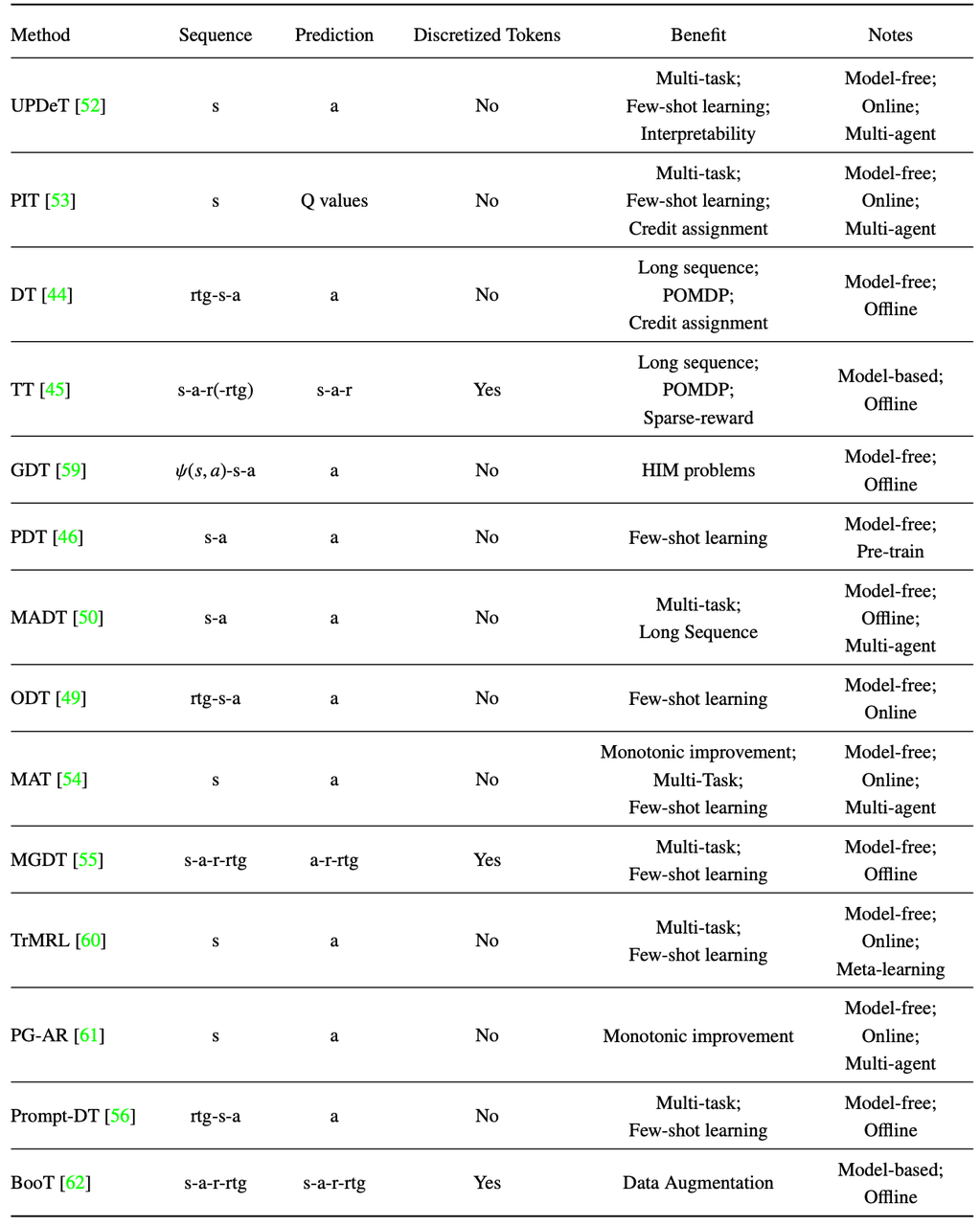

为了研究Transformer在序贯决策领域的发展趋势,数研院在文章中总结了近年来该领域的相关工作,这些工作将强化学习问题转化为序贯形式,并利用序贯模型来处理不同设置下的强化学习问题,如下图所示(截止至22年底,仍在持续扩充中)。

图3:基于Transformer的不同方法在序贯决策制定方面的详细比较

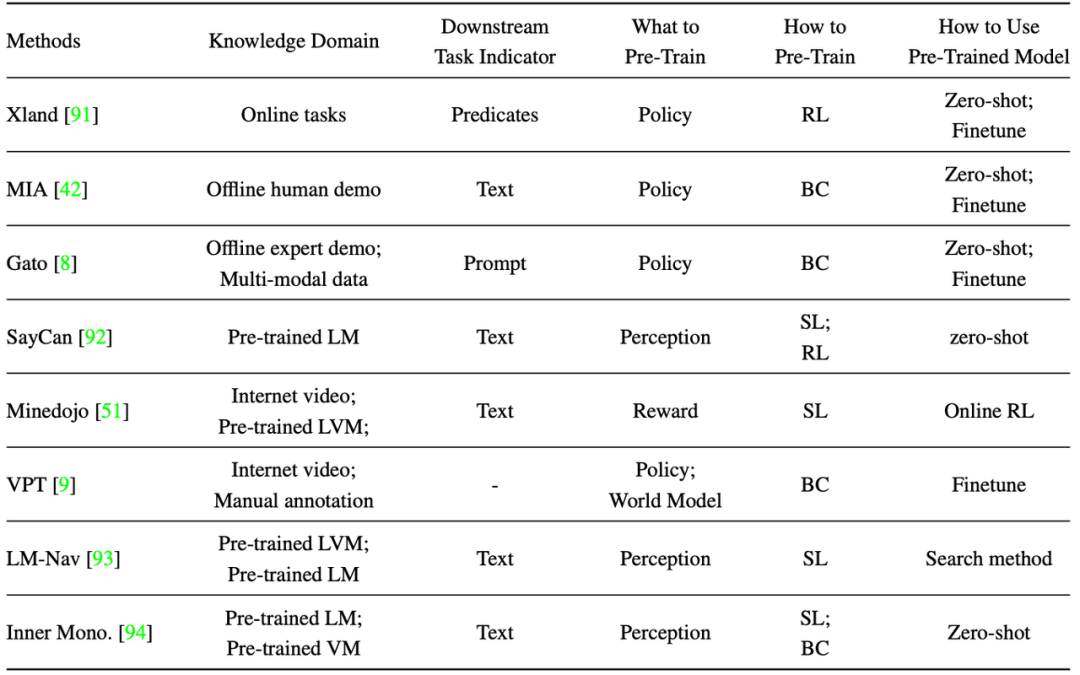

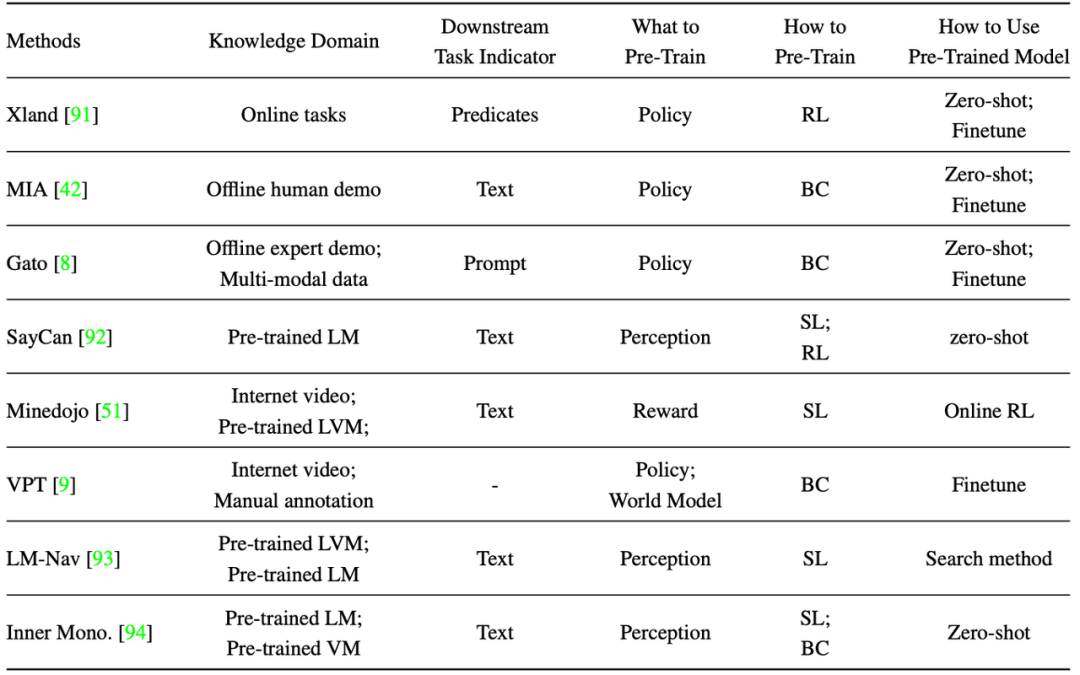

文中还分析了这些模型使用了哪种类型的数据(知识领域)、如何理解zero-shot泛化任务(任务指标)、序贯模型部署了哪种组件(预训练什么)、如何预训练模型以及如何使用预训练模型,以及数据的利用方式。下面是表格中缩写的解释:语言模型(LM)、语言与视觉模型(LVM)和行为克隆(BC),如下图所示。

图4:模型的具体分析

基于本综述,数研院在文中提出了一些当前亟须的研究内容:

1. 理论基础。尽管最近将强化学习问题转化为序贯建模问题带来了许多好处,但相比传统的强化学习方法,也导致了策略优化的理论保证的丧失。因此,在未来,数研院将进一步研究序贯建模方法与传统的强化学习方法的有机结合,提供理论的保证。2. 网络架构。大多数强化学习方法直接依赖于来自NLP和CV的普通Transformer,没有定制化的设计,留下了充足的性能改进空间。未来研究方向包括将RL语义集成到标记设计中,以及利用马尔可夫属性降低计算复杂度。语言知识库与扩散模型也为建模决策序贯提供了新的启示。3. 算法。尽管近年来已经取得了一些进展,但许多具有序列模型的强化学习算法仍然是特定于领域的。因此,能够包括各种强化学习场景的统一框架是未来研究的一个关注点。GPT和多模态BeITv3已经表现出趋向统一上下游任务并取得了显著的成果。虽然 UniMask 正试图在强化学习中统一上下游任务,但它在性能上仍有所不足。因此,在序贯决策制定领域开发一种统一的建模方法仍将是一个关键问题。ChatGPT将成为强大的知识库,但序列决策和感知模态之间的整合还需要改进,探索学习一个额外的模块来将跨模态的大型模型拼接在一起,例如适配器或反向动力学模型。此外,在大型语言模型中出现的上下文学习和思维链能力可能是创建通用自我改进代理的要素,无需从人类获取监督知识。4. 高效训练框架。训练效率代表了阻碍大规模决策模型发展的一个重要障碍,为了设计出高效的训练系统,需要在未来的研究中进行额外的努力和广泛的探索。虽然决策模型的离线预训练在数据流和控制流方面与语言和视觉Transformer相似,但数据加载可能会阻碍其可扩展性。大规模模型的离线数据集可能会超出主机内存甚至计算节点的硬盘容量,因此需要通过网络进行服务。在NLP和CV任务中,训练数据集可以在训练阶段之前进行洗牌,并在epoch期间顺序读取,因此可以通过底层空间局部性实现高效缓存和加速。但是,决策模型的性能和稳定性取决于数据分布,因此需要运行时采样。采样的随机访问行为可能导致缓存策略的高错失率和数据加载的性能不佳。因此,未来的研究需要设计具有高效的数据放置和缓存的训练系统,这对于预训练大型决策模型至关重要。大型决策模型在在线学习阶段需要在推断和训练模式之间不断切换,并定期与环境交互收集训练数据,因此对计算资源的利用效率要求高。现代GPU虽然设计用于并行和批量执行,但现有环境通常是面向CPU的顺序执行,需要额外的抽象层和实现来有效并行化和分布CPU环境。此外,由于GPU-served模型和CPU-served环境具有双向依赖性,整体性能需要从系统性的角度进行优化,包括处理高峰利用率和降低延迟。在大规模训练中,频繁的模式协调通信和同步可能非常昂贵,参数服务器可能成为瓶颈。因此,需要联合设计训练系统和算法来解决这些问题。此前,数研院提出的决策大模型经验回放系统GEAR正是改进了这一问题,它围绕现代GPU系统在数据储存、并行计算和高速通信的软硬件特性优化适用于RL大模型的经验回放过程,分别使用分布式轨迹数据储存、使用GPU加速轨迹数据选择并以GPU为中心进行轨迹收集。实验证明,在同等条件下,GEAR相较于DeepMind Reverb这一常用经验回放系统可提供最高达六倍的数据吞吐量。基于本综述,数研院认为大型决策模型的模型架构应该具有支持多模态、多任务可转移性和稀疏激活的意识,而算法应该解决数据质量和数量的问题。整体培训效率应该通过并行性得到系统地优化。数研院将持续关注并输出对该话题的探讨,未来将赋能在机器人自动化产业以及其他更多的实际应用中。论文链接:https://journal.hep.com.cn/fcs/EN/10.1007/s11704-023-2689-5

上海数字大脑研究院

上海数字大脑研究院汇聚决策智能领域全球领先的科研力量,面向中国及全球产业智能化升级需求,致力于为全球企业提供决策智能解决方案,驱动各产业全面智能化升级。其孵化的独立初创企业谜题科技(Enigma Tech.)是一家致力于破解AGI谜题的创新型公司,公司有着探索未知领域、破解复杂问题、构建AI与人类和谐共处新世界的决心。数研院将携谜题科技一起,继续为人类的生活带来更多美好的可能性,共同开创一个充满智慧与梦想的未来。