欢迎来到「C位」,它是CMC资本团队全新打造的与创业圈、科技产业、学术界分享交流的频道。通过这个窗口,我们关注和记录在当下发生的诸如企业数字化、产业智能化、业务自动化、无人驾驶与智能车、新能源技术、元宇宙等一系列科技领域中的技术前沿、创业实践,以及行业趋势思考,内容形式包括业界对话、行业观察、投资观点等等。我们期望以开放的信息分享和坦诚的观点解构为特色,注重质量,持续输出。

本期「C位观察」由CMC资本投资经理杨航执笔,给大家带来AIGC领域主题研究的上篇:AIGC时代的高性能计算基础设施布局新机遇(上)。

杨航 Stephen Yang

CMC资本 投资经理

专注投资领域:XPU、AI芯片、车载大算力芯片、半导体EDA/IP

长文预警:本文约4400字,

ChatGPT 与 GPT-4 发布所带来的巨大冲击,燃起国内市场对 AIGC 赛道的空前关注。各大互联网和AI企业争先推出自有大模型,在应用端抢占数据与份额。本文着重分析AIGC 的底层基础设施中的计算力部分和AI芯片关键技术架构,这也是 CMC 资本将重点布局的投资方向。

1

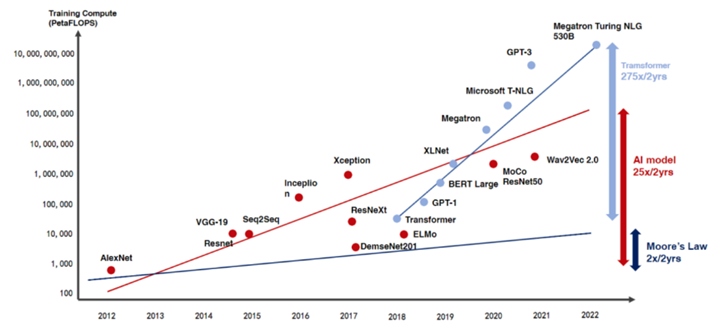

图1:AI模型训练算力增长速度超越芯片摩尔定律

针对大模型训练场景,英伟达在A100芯片后于2023年3月份,再发布可提供更多计算能力的H100。在具体技术实现上,英伟达针对AI计算加速添加Tensor Core,为实现无缝、可扩展的多节点GPU集群推出了NVLink和NVSwitch高速互联方案,通过收购Mellanox补充如:InfiniBand数据互联、RDMA存储等技术,实现在产品性能上全球领先,A100与H100也成为了业内主流的AI开发芯片。

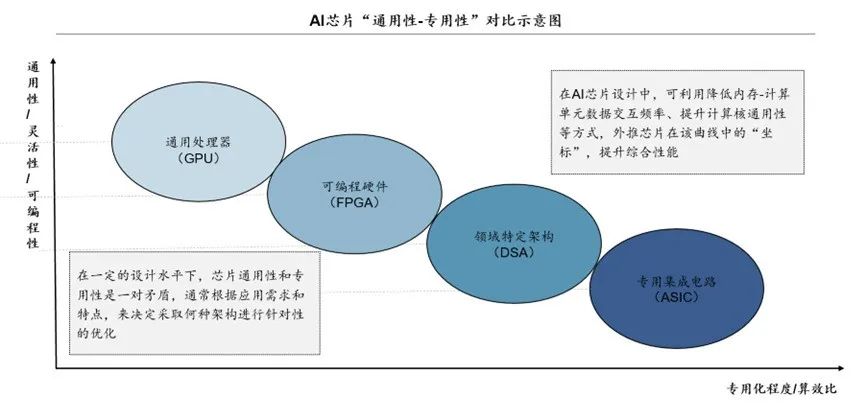

在此背景之下,国内对芯片的自主可控性需求进一步提升。以史为鉴,美国对中国芯片及AI等高科技行业制裁苗头初现时,已涌现大量GPGPU企业,但受制于软件生态、先进制程工艺受限等因素,导致实际落地效果有限,无法满足预期。考虑到此前GPGPU发展的瓶颈,大模型时代下国内也开始广泛探索其他如:FPGA、DSA和ASIC的技术创新路线。FPGA可编程,但编程难度较大,功耗和性能水平一般;ASIC针对场景定制,缺乏可编程性与灵活性,难以满足下游的跨场景、迭代性需求;而DSA设计虽对模型进行了优化,但仍具有一定可编程性与通用性,介于FPGA和ASIC之间,同时性能、功耗等表现优异。

图3:AI芯片“通用性-专用性”对比示意图

2

整体市场空间看,伴随大模型技术逐渐收敛,DSA机遇与风险并存,预计DSA初创企业竞争将加剧

具体而言,DSA设计思路的本质为在制程受限的背景下,贴合算法与模型,实现软件和硬件架构的优化,实现在特定场景下能追平乃至超越GPU的性能。未来伴随AI模型的类型逐渐收敛,DSA整体市场空间将面临增长机遇—— 伴随AI场景和算法逐步成熟,场景对于芯片的通用性及灵活可编程能力要求降低;因此可保证性能、并具备一定可编程能力的DSA芯片有望实现大规模落地。其中,颠覆型DSA或可通过激进的设计,实现性能大幅度提升,同时与模型大厂/云服务厂商深度绑定,实现准确路径预判。数据显示,现阶段颠覆型DSA相较传统GPU与TPU性能可实现3-8x提升,反观TPU较GPU而言高出~25%。具体合作案例看,现阶段微软极其重视与Tensortorrent的合作,以丰富算力供给渠道。

但业内同时持有不一致声音,认为伴随模型收敛,DSA将难以与具备超高通用性与并行计算能力的GPGPU抗衡——1)应用具备高确定性后,在基本单元组件较为一致的情况下,专用架构只能改进数据通路,导致延续DSA逻辑持续优化性能受限;2)模型收敛至Transformer后,DSA架构所能实现的硬件优化皆可转化为CUDA代码优化,DSA失去碾压GPGPU的性能提升空间;3)GPGPU融合更多DSA元素(e.g., 英伟达的Tensor Core),形成软硬件全局完善的闭合逻辑链,通过异构集成拉平技术实力后,在生态上进一步全面碾压DSA。

值得注意的是,模型收敛同时也为DSA初创企业带来了前所未有的挑战,“开卷考试”背景下对兼容性要求降低,更注重对于收敛成熟模型高度绑定后,可实现的性能极致提升,预计不同技术路径的DSA芯片厂商竞争将大幅加剧。

3

具体应用场景看,云端训练侧短期内DSA主要填补垂类中小模型训练空白需求,大模型训练依旧由GPGPU主导。云端推理看,DSA具备市场、技术与竞争三重利好,多重技术路径迸发以提升算力利用率与访存效率,同时降低延时与功耗

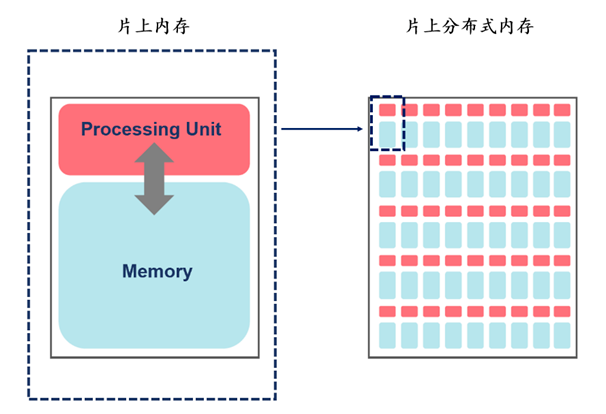

近存计算:与传统的冯诺依曼架构不同,近存计算通过缩短内存到计算单元的距离以实现更强的性能和能耗比,同时叠加超高片上内存与高带宽、低延时的先进互联,以实现高度的可扩展性。通过降低芯片内外数据的频繁搬运活动,以实现功耗、访存延迟与成本的优化。

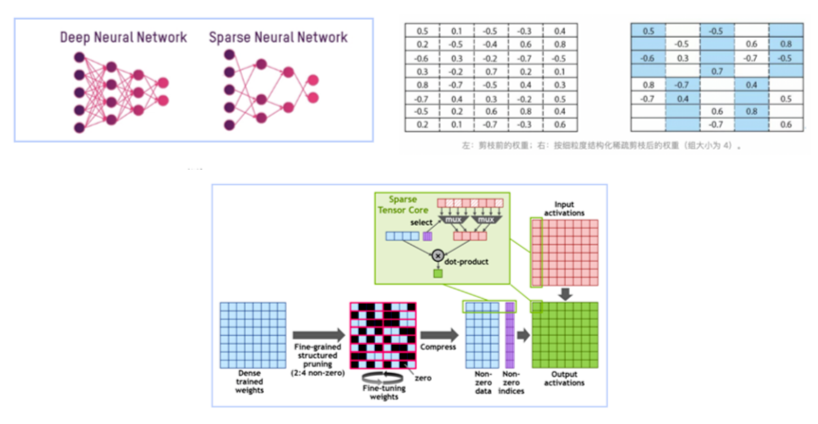

稀疏化:稀疏化技术是指在神经网络中通过对权重进行剪枝或者约束,使得神经网络中权重变得稀疏,即大部分权重为0,以减少神经网络参数量,从而减小模型大小、加速模型推理。

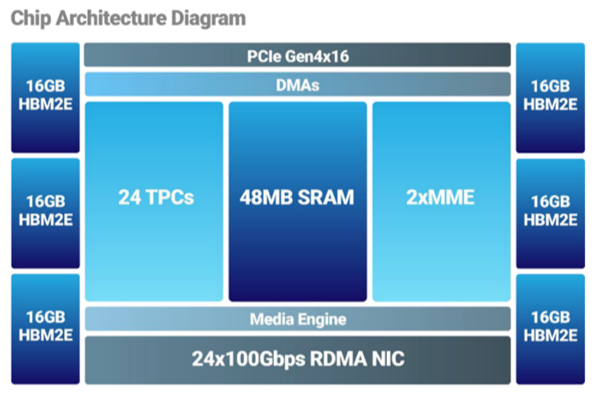

AI引擎异构架构:通过集成主流AI引擎(如:可支持卷积等基础矩阵乘积与其他深度学习算法的引擎),实现并行运作,显著提升计算效率。

4

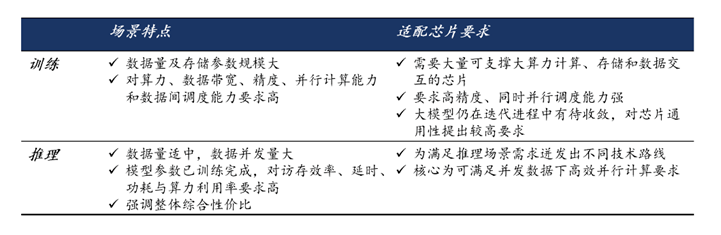

大模型时代下对算力的需求增长迅猛,对训练和推理场景适配的芯片要求也随之发生变化。国产GPGPU受制于技术沉淀、先进制程与软件生态,发展瓶颈凸显。在制程受限的背景下,DSA通过贴合算法模型实现软硬件架构的优化,实现在特定场景下可超越GPU的极致性能,同时具备一定通用性,为AI计算产品体系中值得重点关注的领域。

云端大模型训练场景看,受制于有限的通用性,DSA较难满足大模型迭代需求,预计短期内DSA在大模型训练的机会有限,大模型训练将仍由GPGPU主导,但互联和存储上仍有一定市场机遇——模型训练需要大规模分布式计算,而大模型由于计算量和参数规模庞大,对可扩展性的要求极高,进一步加剧了对先进存储和互联技术的要求。在过去,分布式计算的发展受制于内存性能和互联性能提升与单卡算力性能提升间的错位,导致实际算力利用效率低下。未来伴随内存和互联技术发展,芯片实际算力水平有望实现极致发挥。

云端大模型推理场景看,DSA具备市场、技术与竞争三重利好,为值得重点关注的领域。市场侧推理场景规模具备爆发增长潜力;技术侧对现阶段国内初创企业技术积累更友好,不同技术路线迸发以提升算力利用率与访存效率,降低延时与功耗;竞争侧互联网云巨头自研产品难以满足市场化需求,A800与H800等主流方案缺乏性价比,为初创企业提供充分市场留白。考虑现阶段模型技术路线未完全收敛,与DSA架构芯片设计厂商在软硬件生态上的高研发时间与成本投入,可重点考量DSA不同技术路径的可行性和与未来模型技术路线的贴合度。